Vandaag onthulde het bedrijf op de ontwikkelaarsconferentie van Nvidia, GTC 2024, zijn volgende GPU, de B200. De B200 kan vier keer betere trainingsprestaties leveren, tot 30 keer betere inferentieprestaties en tot 25 keer betere energie-efficiëntie vergeleken met zijn voorganger, de Hopper H100 GPU. Gebaseerd op de nieuwe Blackwell-architectuur kan de GPU worden gecombineerd met de Grace CPU’s van het bedrijf om een nieuwe generatie DGX SuperPOD-computers te vormen die in staat zijn tot 11,5 miljard drijvende-kommabewerkingen (exaflops) aan AI-computergebruik met behulp van een nieuw, laag-precies getal formaat.

“Blackwell is een nieuwe klasse AI-superchips”, zegt Ian Buck, Nvidia’s vice-president van high-performance computing en hyperscale. Nvidia noemde de GPU-architectuur naar wiskundige David Harold Blackwell, de eerste zwarte man die werd opgenomen in de Amerikaanse National Academy of Sciences.

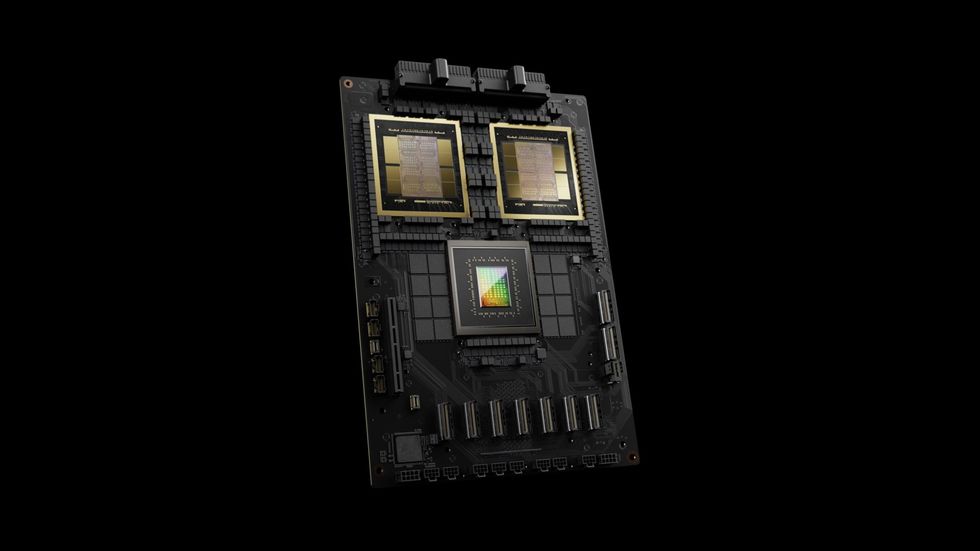

De B200 bestaat uit ongeveer 1.600 vierkante millimeter aan processors op twee siliciumchips die in hetzelfde pakket zijn verbonden via een verbinding van 10 terabyte per seconde, zodat ze werken alsof ze een enkele chip van 208 miljard transistors zijn. Die plakjes silicium zijn gemaakt met behulp van TSMC’s N4P-chiptechnologie, die een prestatieverbetering van 6 procent oplevert ten opzichte van de N4-technologie die wordt gebruikt om GPU’s met Hopper-architectuur zoals de H100 te maken.

Net als de Hopper-chips is de B200 omgeven door geheugen met hoge bandbreedte, wat steeds belangrijker wordt voor het verminderen van de latentie en het stroomverbruik van grote AI-modellen. Het geheugen van de B200 is van het nieuwste type, HBM3e, en heeft in totaal 192 GB (vergeleken met 141 GB voor de Hopper-chip van de tweede generatie, de H200). Bovendien wordt de geheugenbandbreedte vergroot tot 8 terabytes per seconde met de H200 op 4,8 TB/s.

Kleinere aantallen, snellere chips

Chipproductietechnologie heeft een deel van het werk gedaan bij het maken van de Blackwell, maar het is wat de GPU doet met de transistors die echt het verschil maakt. Nvidia’s hoofdwetenschapper Bill Dally legde het AI-succes van Nvidia vorig jaar uit aan computerwetenschappers bij IEEE Hot Chips en zei dat het grootste deel ervan voortkomt uit het gebruik van steeds minder bits om getallen in AI-berekeningen weer te geven. Blackwell zet die trend voort.

De architectuur van zijn voorganger, de Hopper, was het eerste exemplaar van wat Nvidia een transformatormotor noemt. Het is een systeem dat elke laag van het neurale netwerk onderzoekt en bepaalt of deze kan worden berekend met behulp van getallen met een lagere nauwkeurigheid. In het bijzonder kan Hopper drijvende-kommagetalformaten gebruiken die zo groot zijn als 8 bits. Kleinere getallen zijn sneller en energiezuiniger om te berekenen, vereisen minder geheugen en geheugenbandbreedte, en de logica die nodig is om de berekeningen uit te voeren, neemt minder silicium in beslag.

“Met Blackwell zijn we nog een stap verder gegaan”, zegt Buck. De nieuwe architectuur heeft eenheden die matrixberekeningen uitvoeren met getallen met drijvende komma van slechts 4 bits breed. Bovendien kan het ervoor kiezen om ze over delen van elke laag van het neurale netwerk te verspreiden, in plaats van alleen over de hele lagen zoals Hopper. “Het bereiken van dat niveau van fijne granulariteit is op zichzelf al een wonder”, zegt Buck.

NVLink en andere functies

Een van de andere architecturale inzichten die Nvidia over Blackwell onthulde, is dat het een speciale “engine” bevat die zich toelegt op GPU-betrouwbaarheid, beschikbaarheid en onderhoudsgemak. Volgens Nvidia gebruikt het een op AI gebaseerd systeem om diagnostiek uit te voeren en betrouwbaarheidsproblemen te voorspellen, met als doel de uptime te vergroten en enorme AI-systemen wekenlang ononderbroken te laten draaien, de periode die vaak nodig is om grote taalmodellen te trainen.

Nvidia heeft ook systemen toegevoegd om AI-modellen veilig te houden en gegevens te decomprimeren om databasequery’s en gegevensanalyse te versnellen.

Ten slotte bevat Blackwell Nvidia’s vijfde generatie NVLink compute interconnect-technologie, die nu 1,8 terabytes per seconde bidirectioneel tussen GPU’s levert en snelle communicatie tussen maximaal 576 GPU’s mogelijk maakt. Hoppers versie van NVLink kon slechts de helft van die bandbreedte bereiken.

SuperPOD en andere computers

De bandbreedte van NVLink is de sleutel tot het bouwen van Blackwell-supercomputers die in staat zijn neurale netwerkmodellen met biljoenen parameters te doorbreken.

De basiscomputereenheid heet de DGX GB200. Elk van hen bevat 36 GB200-superchips. Dit zijn modules met onder meer een Grace CPU en twee Blackwell GPU’s, allemaal aan elkaar gekoppeld met NVLink.

De Grace Blackwell-superchip bestaat uit twee Blackwell GPU’s en een Grace CPU in dezelfde module.Nvidia

De Grace Blackwell-superchip bestaat uit twee Blackwell GPU’s en een Grace CPU in dezelfde module.Nvidia

Acht DGX GB200’s kunnen via NVLINK verder worden aangesloten om een supercomputer met 576 GPU te vormen, de DGX SuperPOD. Nvidia zegt dat zo’n computer 11,5 exaflops kan doorlopen met behulp van 4-bit precisieberekeningen. Systemen van tienduizenden GPU’s zijn mogelijk met behulp van de Quantum Infiniband-netwerktechnologie van het bedrijf.

Het bedrijf zegt te verwachten dat de SuperPOD en andere Nvidia-computers later dit jaar beschikbaar zullen komen. Ondertussen hebben chipgieterij TSMC en elektronisch ontwerpautomatiseringsbedrijf Synopsys aangekondigd dat ze Nvidia’s inverse lithografietool, cuLitho, in productie zullen nemen. Ten slotte kondigde Nvidia een nieuw fundamenteel model voor humanoïde robots aan, de GR00T.