In de afgelopen maanden hebben we de nep-robocall van Joe Biden gezien die de kiezers in New Hampshire aanmoedigde om “uw stem te bewaren voor de verkiezingen in november” en de valse goedkeuring van Donald Trump door Taylor Swift. Het is duidelijk dat 2024 de eerste ‘AI-verkiezingen’ in de geschiedenis van de Verenigde Staten zullen markeren.

Terwijl veel voorstanders oproepen tot waarborgen tegen de potentiële schade van AI aan onze democratie, kondigde Meta (het moederbedrijf van Facebook en Instagram) vorige maand trots aan dat het door AI gegenereerde inhoud die is gemaakt met behulp van de meest populaire generatieve AI-tools een label zal geven. Het bedrijf zei dat het “een toonaangevend hulpmiddel bouwt dat onzichtbare markeringen op schaal kan identificeren – met name de ‘AI-gegenereerde’ informatie in de technische standaarden C2PA en IPTC.”

Helaas zullen sociale netwerken met deze aanpak het probleem van deepfakes op sociale netwerken dit jaar niet oplossen. Deze nieuwe inspanning zal inderdaad heel weinig bijdragen aan de aanpak van het probleem van door AI gegenereerd materiaal dat de verkiezingsomgeving vervuilt.

De meest voor de hand liggende zwakte is dat het systeem van Meta alleen zal werken als slechte actoren die deepfakes creëren, tools gebruiken die hun afbeeldingen al van een watermerk voorzien (dat wil zeggen verborgen of zichtbare informatie over de oorsprong van digitale inhoud). Onbeveiligde ‘open source’ generatieve AI-tools produceren over het algemeen helemaal geen watermerken. (We gebruiken de term onbeschermd en zetten ‘open source’ tussen aanhalingstekens om aan te geven dat veel van dergelijke tools niet voldoen aan de traditionele definities van open source software, maar nog steeds een bedreiging vormen omdat hun onderliggende code of modelgewichten openbaar beschikbaar zijn.) Als Als er nieuwe versies worden uitgebracht van deze onbeschermde tools die watermerken bevatten, zullen de oude tools nog steeds beschikbaar zijn en inhoud zonder watermerk kunnen produceren, inclusief gepersonaliseerde en zeer overtuigende desinformatie en neppornografie zonder wederzijds goedvinden.

We zijn ook bezorgd dat slechte actoren het tagging-regime van Meta gemakkelijk kunnen omzeilen, zelfs als ze de AI-tools gebruiken waarvan Meta zegt dat ze gedekt zullen worden, waaronder producten van Google, OpenAI, Microsoft, Adobe, Midjourney en Shutterstock. Gezien het feit dat het ongeveer twee seconden duurt om een watermerk te verwijderen van een afbeelding die is geproduceerd met behulp van de huidige C2PA-watermerkstandaard die door deze bedrijven wordt geïmplementeerd, valt de belofte van Meta om door AI gegenereerde afbeeldingen van een watermerk te voorzien in duigen.

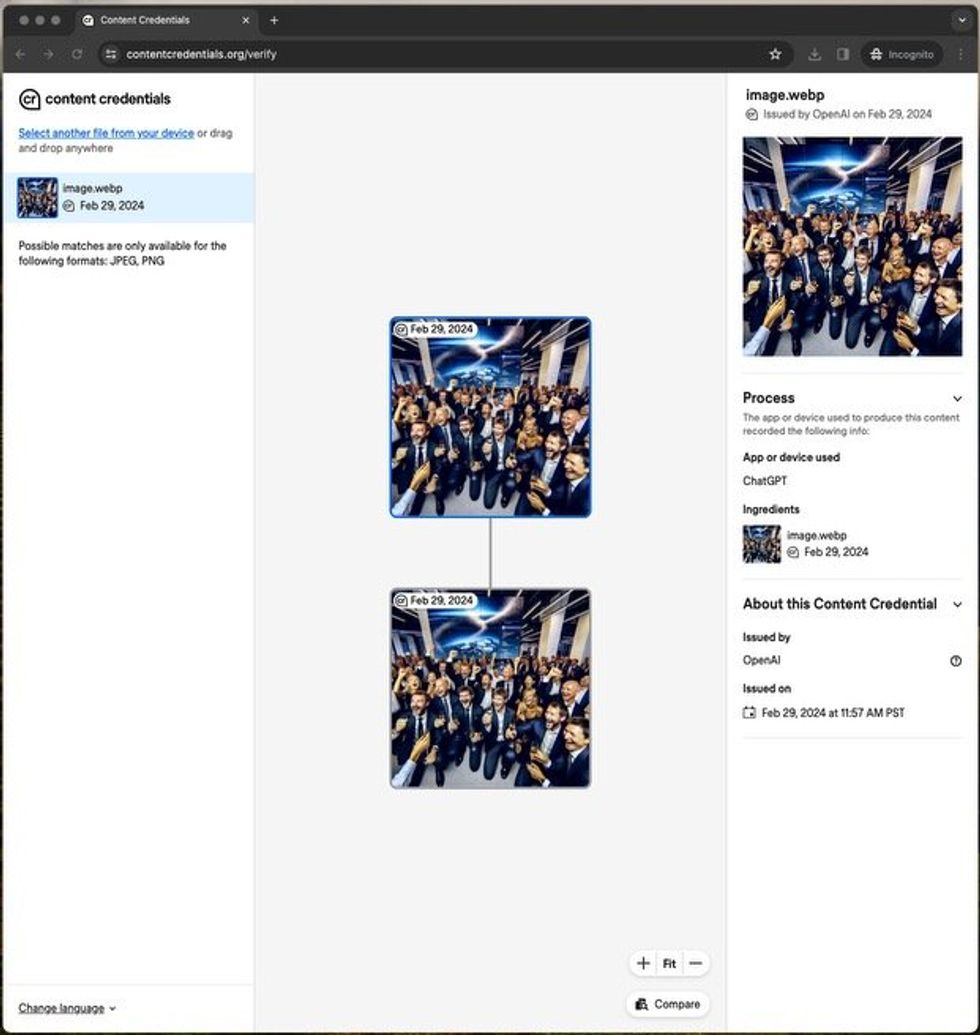

Toen de auteurs de door hen gegenereerde afbeelding uploadden naar een website die watermerken verifieerde, vermeldde de pagina terecht dat het een synthetische afbeelding was, gegenereerd door een OpenAI-tool. IEEE-spectrum

Toen de auteurs de door hen gegenereerde afbeelding uploadden naar een website die watermerken verifieerde, vermeldde de pagina terecht dat het een synthetische afbeelding was, gegenereerd door een OpenAI-tool. IEEE-spectrum

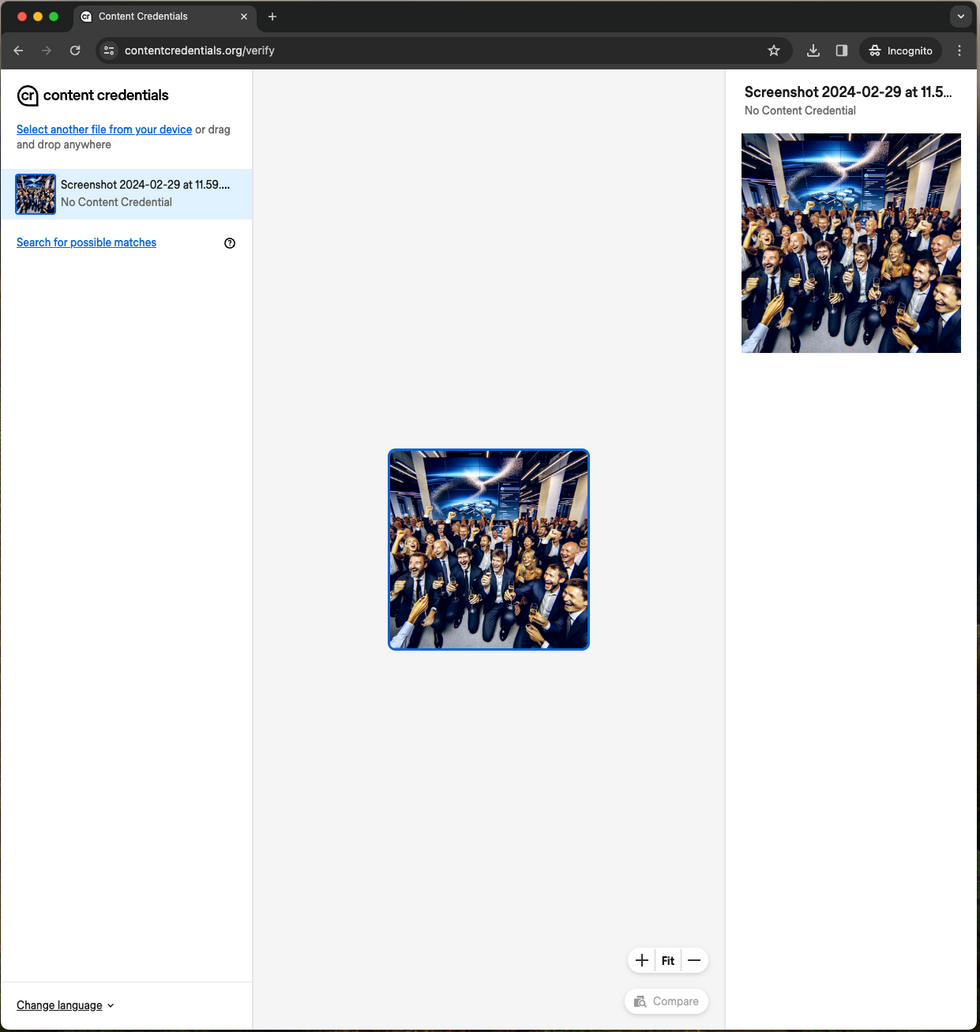

We weten dit omdat we de watermerken die Meta beweert te detecteren gemakkelijk konden verwijderen – en niemand van ons is een ingenieur. We hoefden ook geen enkele regel code te schrijven of software te installeren.

Eerst hebben we de afbeelding gegenereerd met DALL-E 3 van OpenAI. Vervolgens hebben we, om te zien of het watermerk werkt, de afbeelding geüpload naar de C2PA-website voor verificatie van de inloggegevens. Een eenvoudige en elegante interface liet ons zien dat deze afbeelding inderdaad gemaakt was met OpenAI’s DALL-E 3. Dus hoe hebben we het watermerk verwijderd? Door het scherm op te nemen. Toen we de schermafbeelding naar dezelfde verificatiesite uploadden, vond de verificatiesite geen bewijs dat de afbeelding door AI was gegenereerd. Hetzelfde proces werkte toen we een afbeelding maakten met Meta’s AI-beeldgenerator en deze vastlegden – en deze uploadden naar een website die de IPTC-metagegevens detecteert die Meta’s AI-“watermerk” bevat.

Toen de auteurs echter een screenshot van de afbeelding maakten en die screenshot ter verificatie naar dezelfde locatie uploadden, vond de site geen watermerk en dus geen bewijs dat de afbeelding door kunstmatige intelligentie was gegenereerd. IEEE-spectrum

Toen de auteurs echter een screenshot van de afbeelding maakten en die screenshot ter verificatie naar dezelfde locatie uploadden, vond de site geen watermerk en dus geen bewijs dat de afbeelding door kunstmatige intelligentie was gegenereerd. IEEE-spectrum

Is er een betere manier om door AI gegenereerde inhoud te identificeren?

In de aankondiging van Meta staat dat het “hard werkt om classificaties te ontwikkelen die kunnen helpen… om door AI gegenereerde inhoud automatisch te detecteren, zelfs als de inhoud onzichtbare markeringen mist.” Het is leuk dat het bedrijf eraan werkt, maar totdat het slaagt en deze technologie met de hele industrie deelt, zullen we ons blijven afvragen of alles wat we online zien of horen echt is.

Voor een meer onmiddellijke oplossing zou de industrie kunnen kiezen maximaal onuitwisbaar watermerken: watermerken die zo moeilijk mogelijk te verwijderen zijn.

De huidige imperfecte watermerken hechten meestal informatie aan het bestand in de vorm van metagegevens. Om maximaal onuitwisbare watermerken een verbetering te bieden, moeten ze naadloos informatie verbergen in daadwerkelijke beeldpixels, audiogolfvormen (Google Deepmind beweert dit te hebben gedaan met zijn eigen SynthID-watermerk), of door licht gewijzigde woordfrequentiepatronen in door AI gegenereerde tekst. We gebruiken de term ‘maximaal’ om te erkennen dat er misschien nooit een perfect onuitwisbaar watermerk zal zijn. Het is echter niet alleen een probleem met watermerken. De gevierde beveiligingsexpert Bruce Schneier merkt op dat “computerbeveiliging geen oplosbaar probleem is… Beveiliging is altijd een wapenwedloop geweest en dat zal altijd zo blijven.”

In metaforische zin is het leerzaam om stil te staan bij autoveiligheid. Geen enkele autofabrikant heeft ooit een crashbestendige auto geproduceerd. Toch heeft dat de toezichthouders er niet van weerhouden uitgebreide veiligheidsnormen te implementeren die veiligheidsgordels, airbags en achteruitrijcamera’s op auto’s vereisen. Als we zouden wachten tot de beveiligingstechnologieën geperfectioneerd waren voordat we de implementatie van de best beschikbare opties zouden eisen, zouden we op veel terreinen veel slechter af zijn.

Er is steeds meer politiek momentum in de strijd tegen deepfakes. Vijftien van de grootste AI-bedrijven – waaronder vrijwel alle bedrijven die in dit artikel worden genoemd – ondertekenden vorig jaar de AI Voluntary Commitments van het Witte Huis, die een belofte inhielden om “robuuste mechanismen te ontwikkelen, inclusief herkomst- en/of watermerksystemen voor audio- of visuele inhoud” en om “tools of API’s te ontwikkelen om te bepalen of een bepaald stuk inhoud met hun systeem is gemaakt.” Helaas heeft het Witte Huis geen tijdlijn vastgesteld voor vrijwillige toezeggingen.

Vervolgens definieerde het Witte Huis in oktober AI-watermerken in zijn AI-uitvoerend besluit als ‘de handeling van het inbedden van informatie, die doorgaans moeilijk te verwijderen is, in door AI gegenereerde output – inclusief output zoals foto’s, video’s, audio-opnamen of tekst – voor de met als doel de authenticiteit van het resultaat of de identiteit of kenmerken van de oorsprong, wijziging of overdracht ervan te verifiëren.”

Vervolgens ondertekende een groep van twintig technologiebedrijven (waarvan de helft eerder vrijwillige toezeggingen had ondertekend) op de Veiligheidsconferentie van München op 16 februari een nieuwe ‘Technische overeenkomst ter bestrijding van het misleidende gebruik van AI bij de verkiezingen van 2024’. Zonder specifieke toezeggingen te doen of tijdlijnen te geven, biedt de overeenkomst een vage intentie om een vorm van watermerken te implementeren of pogingen te ondernemen om de bron van de inhoud te achterhalen. Hoewel de standaard niet gespecificeerd is, noemt de overeenkomst zowel C2PA als SynthID als voorbeelden van technologieën die kunnen worden toegepast.

Kan regelgeving helpen?

We hebben voorbeelden gezien van sterke weerstand tegen deepfakes. Na de door AI gegenereerde robocalls aan Biden startte het ministerie van Justitie van New Hampshire een onderzoek in samenwerking met staats- en federale partners, waaronder een tweeledige taskforce van alle vijftig procureurs-generaal en de Federal Communications Commission. Ondertussen verduidelijkte de FCC begin februari dat oproepen waarbij AI wordt gebruikt om de stem te genereren als kunstmatig zullen worden beschouwd en onderworpen zullen zijn aan beperkingen onder de bestaande wetgeving inzake robocalls.

Helaas hebben we geen wetten die AI-ontwikkelaars of sociale-mediabedrijven dwingen actie te ondernemen. Het Congres en de staten moeten verplichten dat alle generatieve kunstmatige-intelligentieproducten zoveel mogelijk onuitwisbare watermerken in hun afbeeldingen, audio, video en tekstuele inhoud insluiten met behulp van de modernste technologie. Ze moeten ook de risico’s aanpakken van onbeveiligde “open source”-systemen waarbij de watermerkfunctionaliteit is uitgeschakeld of die worden gebruikt om watermerken van andere inhoud te verwijderen. Bovendien moet elk bedrijf dat een generatieve AI-tool produceert, worden aangemoedigd om een detector uit te brengen die alle inhoud die het produceert met de hoogst mogelijke nauwkeurigheid kan identificeren. Dit voorstel mag niet controversieel zijn, aangezien de ruwe contouren ervan al zijn overeengekomen door de ondertekenaars van de vrijwillige toezeggingen en het recente verkiezingsakkoord.

Standaardorganisaties zoals C2PA, het National Institute of Standards and Technology en de International Organization for Standardization zouden ook sneller actie moeten ondernemen om consensus te bereiken en standaarden te publiceren voor maximaal onuitwisbare watermerken en inhoudslabels ter voorbereiding op wetgeving die deze technologieën vereist. Google zou, als nieuwste lid van de raad van bestuur van C2PA, ook snel actie moeten ondernemen om zijn ogenschijnlijk best-in-class SynthID-watermerktechnologie open te stellen voor leden om te testen.

Verkeerde informatie en kiezersbedrog zijn niets nieuws bij verkiezingen. Maar kunstmatige intelligentie versnelt de bestaande bedreigingen voor onze toch al kwetsbare democratie. Het Congres moet ook overwegen welke stappen het kan nemen om onze verkiezingen in het algemeen te beschermen tegen degenen die ze proberen te ondermijnen. Dat zou een aantal basisstappen moeten omvatten, zoals het aannemen van de Wet op het misleiden en intimideren van kiezers, die het illegaal zou maken om willens en wetens tegen kiezers te liegen over het tijdstip, de plaats en de manier van verkiezingen, met de bedoeling hen te beletten in de aanloop naar hun stem uit te brengen. naar federale verkiezingen.

Het Congres is bedroevend traag geweest met het doorvoeren van alomvattende democratische hervormingen, ondanks de recente schokken. De potentiële versterking van deze schokken door AI-misbruik zou voldoende moeten zijn om wetgevers eindelijk tot actie te dwingen.

Uit artikelen op uw website

Gerelateerde artikelen op internet