DAVID VINTINER

Vervolgens vraagt hij me om een script voor een fictieve YouTuber in verschillende tonen voor te lezen, waarbij hij me begeleidt bij de reeks emoties die ik moet overbrengen. Eerst moet ik het op een neutrale, informatieve manier lezen, dan op een bemoedigende manier, geïrriteerd en verdrietig, en ten slotte op een opgewonden, overtuigende manier.

‘Hé allemaal, welkom terug Til haar op met zijn gastheer, Jess Mars. Het is geweldig dat je hier bent. We staan op het punt een onderwerp aan te pakken dat nogal delicaat is en ons echt raakt: omgaan met kritiek op onze spirituele reis,’ las ik voor uit de teleprompter, terwijl ik mezelf probeerde te visualiseren terwijl ik met mijn partner sprak tijdens de hoger beroep-versie. . “Overal waar je kijkt, lijkt er altijd een kritische stem te zijn die klaar staat om in te grijpen, nietwaar?”

Wees geen afval, wees geen afval, wees geen afval.

“Dat was echt goed. Ik keek ernaar en dacht: ‘Nou, dit is waar. Hij klaagt zeker,’ zegt Oshinyemi bemoedigend. Voeg de volgende keer misschien een gerecht toe, stelt hij voor.

We maken verschillende shots met verschillende varianten van het scenario. In sommige versies mag ik mijn handen bewegen. In andere gevallen vraagt Oshinyemi mij om een metalen naald tussen mijn vingers te houden, zoals ik dat doe. Dit is om de ‘randen’ van de mogelijkheden van de technologie op het gebied van handcommunicatie te testen, zegt Oshinyemi.

Historisch gezien was het een zeer moeilijke uitdaging om AI-avatars er natuurlijk uit te laten zien en mondbewegingen aan spraak te laten matchen, zegt David Barber, een professor in machine learning aan het University College London, die niet betrokken is bij het werk van Synthesia. Dit komt omdat het probleem verder gaat dan mondbewegingen; je moet denken aan de wenkbrauwen, alle spieren in het gezicht, het schouderophalen en de vele verschillende kleine gebaren die mensen gebruiken om zich uit te drukken.

DAVID VINTINER

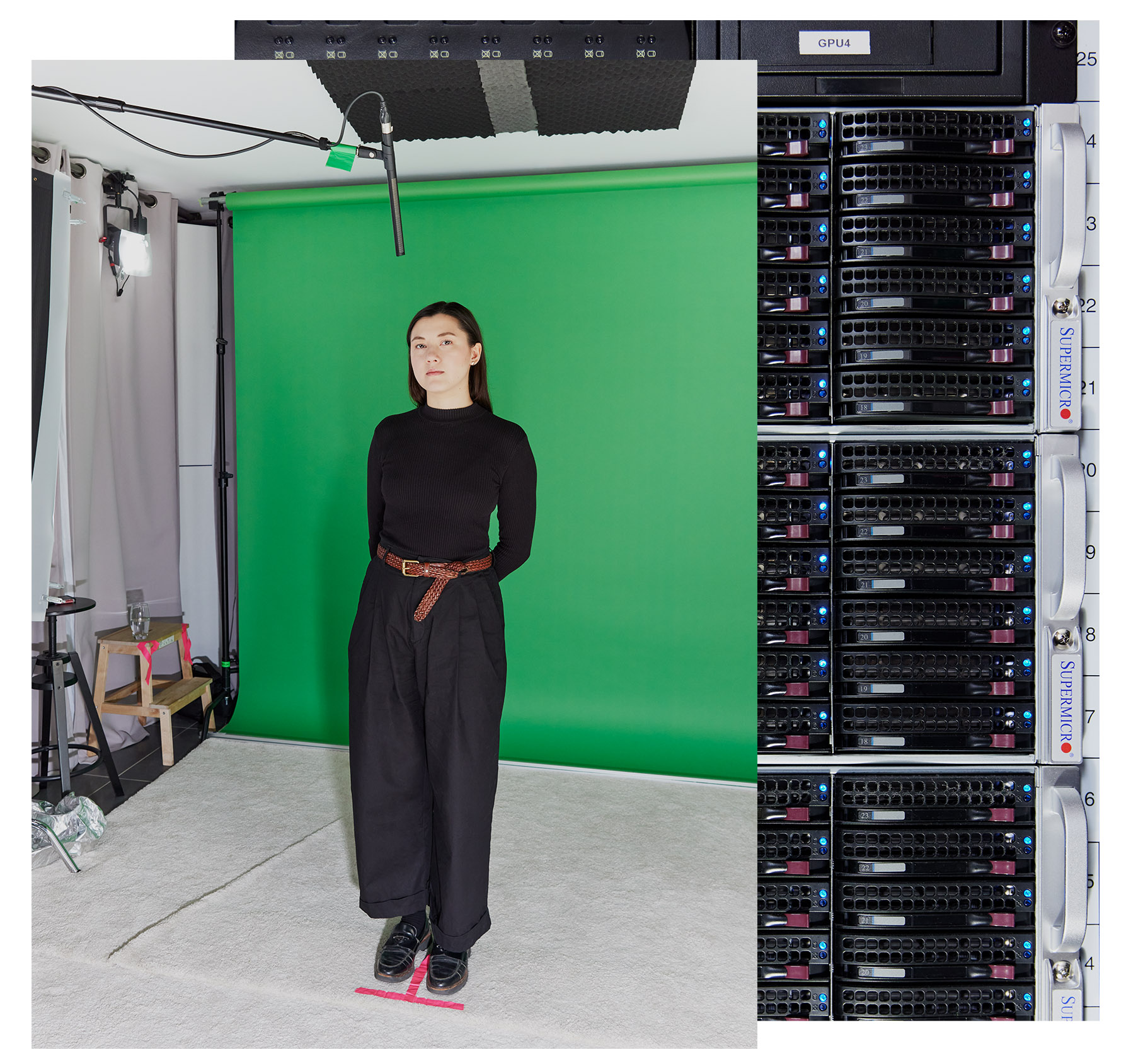

Synthesia werkt sinds 2020 samen met acteurs om zijn modellen te trainen, en hun dubbelgangers vormen 225 avatars die klanten kunnen animeren met hun eigen scenario’s. Maar om haar nieuwste generatie avatars te trainen had Synthesia meer gegevens nodig; het afgelopen jaar werkte hij met ongeveer 1.000 professionele acteurs in Londen en New York. (Synthesia zegt dat het de gegevens die het verzamelt niet verkoopt, hoewel het een deel ervan wel vrijgeeft voor academische onderzoeksdoeleinden.)

Acteurs werden voorheen betaald telkens wanneer hun avatar werd gebruikt, maar nu betaalt het bedrijf hen vooraf een vergoeding om het AI-model te trainen. Synthesia gebruikt haar avatars drie jaar lang, waarna acteurs wordt gevraagd of ze hun contract willen verlengen. Als dat zo is, komen ze naar de studio om een nieuwe avatar te maken. Als dit niet het geval is, verwijdert het bedrijf hun gegevens. Zakelijke gebruikers van Synthesia kunnen ook hun eigen aangepaste avatars genereren door iemand naar de studio te sturen om veel van wat ik doe te doen.