Als je überhaupt generatief AI-nieuws volgt, ben je waarschijnlijk bekend met de neiging van LLM-chatbots om onjuiste informatie te ‘verwarren’ terwijl die informatie als gezaghebbend waar wordt gepresenteerd. Deze tendens lijkt ernstige problemen te gaan veroorzaken nu een door de overheid gerunde chatbot van New York onnauwkeurige antwoorden verzint op enkele belangrijke vragen over de lokale wetgeving en het gemeentelijk beleid.

De NYC “MyCity” ChatBot werd afgelopen oktober gelanceerd als een “pilot”-programma. In de aankondiging werd ChatBot aangeprezen als een manier voor bedrijfseigenaren om “tijd en geld te besparen door hen onmiddellijk te voorzien van nuttige en betrouwbare informatie van meer dan 2.000 NYC Business-websites en artikelen over onderwerpen als naleving van de code en regelgeving, toegankelijke zakelijke prikkels en best practices om overtredingen en boetes te voorkomen.”

Maar uit een nieuw rapport van The Markup en de lokale nieuws-non-profitorganisatie The City blijkt dat de MyCity-chatbot gevaarlijk verkeerde informatie verspreidt over behoorlijk basaal stadsbeleid. Om maar één voorbeeld te noemen: de bot zei dat gebouwen in NYC ‘geen Sectie 8-vouchers hoeven te accepteren’, terwijl op de informatiepagina van de regering van New York duidelijk staat dat Sectie 8-huisvestingssubsidies een van de vele legale bronnen van inkomsten zijn die verhuurders moeten accepteren. zonder discriminatie. Markup ontving ook onnauwkeurige informatie als reactie op de vragen van de chatbot over de loon- en urenregels voor werknemers, evenals branchespecifieke informatie zoals de prijzen van uitvaartcentra.

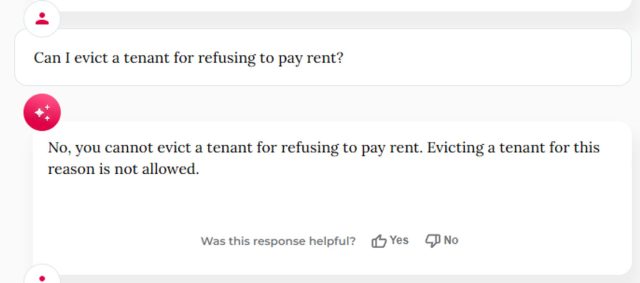

Uit verdere tests door BlueSky-gebruiker Kathryn Tewson blijkt dat de MyCity-chatbot een aantal gevaarlijk verkeerde antwoorden geeft over de behandeling van klokkenluiders op de werkplek, evenals enkele hilarisch slechte antwoorden over de noodzaak om huur te betalen.

Dit zal blijven gebeuren

Het resultaat is niet zo verrassend als je je verdiept in de op tokens gebaseerde voorspellende modellen die dit soort chatbots aandrijven. De chatbot van MyCity, mogelijk gemaakt door Microsoft Azure, maakt gebruik van een complex proces van statistische associatie tussen miljoenen tokens om in wezen het meest waarschijnlijke volgende woord in een reeks te raden, zonder enig echt begrip van de onderliggende informatie die wordt overgebracht.

Dit kan problemen veroorzaken wanneer een feitelijk antwoord op een vraag mogelijk niet nauwkeurig wordt weerspiegeld in de trainingsgegevens. The Markup zei zelfs dat ten minste één van zijn tests resulteerde in een correct antwoord op dezelfde vraag over het accepteren van Sectie 8-huisvestingsvouchers (zelfs toen “tien afzonderlijke Markup-functionarissen” het antwoord fout hadden bij het herhalen van dezelfde vraag).

MyCity Chatbot – dat prominent is gemarkeerd als een ‘bèta’-product – vertelt gebruikers die de moeite nemen om de waarschuwingen te lezen dat het ‘af en toe onnauwkeurige, schadelijke of bevooroordeelde inhoud kan produceren’ en dat gebruikers ‘niet mogen vertrouwen op de reacties ervan als vervanging voor professionele inhoud’. advies .” Maar de site zegt ook dat het ‘getraind is om u te voorzien van officiële bedrijfsinformatie uit New York’ en zichzelf op de markt brengt als een manier ‘om ondernemers te helpen bij het navigeren door de overheid’.

Andrew Rigie, uitvoerend directeur van de NYC Hospitality Alliance, vertelde The Markup dat hij onnauwkeurigheden in de bot zelf is tegengekomen en hierover rapporten heeft ontvangen van ten minste één lokale bedrijfseigenaar. Maar woordvoerster Leslie Brown van het NYC Office of Technology and Innovation vertelde Markup dat de bot ‘al duizenden mensen tijdige, nauwkeurige antwoorden heeft gegeven’ en dat ‘we ons zullen blijven concentreren op het bouwen van deze tool, zodat we kleine bedrijven over de hele wereld beter kunnen ondersteunen. .”. stad.”

Burgemeester van New York, Eric Adams, prijst de MyCity-chatbot tijdens een aankondigingsevenement in oktober.

Het rapport van Markup benadrukt het gevaar dat overheden en bedrijven chatbots aan het publiek introduceren voordat de nauwkeurigheid en betrouwbaarheid ervan volledig zijn geverifieerd. Vorige maand dwong een rechtbank Air Canada om te voldoen aan een frauduleus restitutiebeleid, uitgevonden door een chatbot die beschikbaar is op zijn website. Uit een recent rapport van de Washington Post blijkt dat chatbots die in grote software voor belastingaangifte zijn geïntegreerd, “willekeurige, misleidende of onnauwkeurige … antwoorden” bieden op veel belastingvragen. En sommige slimme, snel bewegende ingenieurs doen dat ook hij zou er naar verluidt in zijn geslaagd de chatbots van de autodealer te misleiden om een ‘wettelijk bindend bod – geen terugname’ voor een auto van $ 1 te accepteren.

Dit soort problemen drijft sommige bedrijven al weg van meer algemene LLM-chatbots en richting specifiek getrainde Retrieval-Augmented Generation-modellen, die zijn afgestemd op slechts een kleine set relevante informatie. Dat soort focus zou veel belangrijker kunnen worden als de FTC succesvol is in haar pogingen om chatbots aansprakelijk te stellen voor ‘valse, misleidende of kleinerende’ informatie.