Het bijhouden van een snel evoluerende industrie als AI is een hele opgave. Dus hoewel AI het niet voor je kan doen, is hier een handig overzicht van recente verhalen in de wereld van machinaal leren, samen met opmerkelijk onderzoek en experimenten die we zelf niet hebben behandeld.

Deze week in AI is de nieuwscyclus eindelijk (eindelijk!) tot rust gekomen, vlak voor de feestdagen. Maar dat betekent niet dat er een gebrek aan schrijven was, een zegen en een vloek voor deze journalist met slaapgebrek.

Een kop van de AP trok vanochtend mijn aandacht: “AI-beeldgeneratoren zijn getraind op expliciete foto’s van kinderen.” Het komt erop neer dat LAION, de dataset die wordt gebruikt om veel populaire open source en commerciële AI-beeldgeneratoren te trainen, waaronder Stable Diffusion en Imagen, duizenden afbeeldingen bevat van verdachten van kindermisbruik. Een in Stanford gevestigde waakhondgroep, de Stanford Internet Observatory, werkte samen met liefdadigheidsorganisaties tegen misbruik om illegaal materiaal te identificeren en de links aan de politie te melden.

Nu heeft LAION, een non-profitorganisatie, haar trainingsgegevens verwijderd en beloofd het aanstootgevende materiaal te verwijderen voordat het opnieuw wordt gepubliceerd. Maar het incident onderstreept hoe weinig aandacht wordt besteed aan generatieve AI-producten nu de concurrentiedruk toeneemt.

Dankzij de toename van tools voor het creëren van codevrije AI-modellen wordt het ongelooflijk eenvoudig om generatieve AI te trainen op elke denkbare dataset. Het is een zegen voor startups en technologiegiganten om dergelijke modellen de deur uit te krijgen. Met een lagere toetredingsdrempel ontstaat echter de verleiding om de ethiek terzijde te schuiven ten gunste van een snelle marktintroductie.

Ethiek is moeilijk, dat valt niet te ontkennen. Het doorzoeken van de duizenden problematische beelden in LAION, om het voorbeeld van deze week te nemen, zal niet van de ene op de andere dag gebeuren. Idealiter omvat de ethische ontwikkeling van AI het samenwerken met alle relevante belanghebbenden, inclusief organisaties die groepen vertegenwoordigen die vaak worden gemarginaliseerd en negatief worden beïnvloed door AI-systemen.

De sector staat vol met voorbeelden van beslissingen over de vrijgave van AI die worden genomen met de aandeelhouders in gedachten, en niet met ethici. Neem bijvoorbeeld Bing Chat (nu Microsoft Copilot), de AI-aangedreven chatbot van Microsoft op Bing, die bij de lancering journalisten met Hitler vergeleek en hun uiterlijk beledigde. Vanaf oktober bleven ChatGPT en Bard, de ChatGPT-concurrent van Google, verouderde, racistische medische adviezen geven. En de nieuwste versie van OpenAI’s DALL-E-beeldgenerator vertoont tekenen van anglocentrisme.

Het volstaat te zeggen dat er schade wordt aangericht bij het nastreven van AI-superioriteit – of op zijn minst Wall Street’s idee van AI-superioriteit. Misschien gloort er enige hoop aan de horizon met de inwerkingtreding van de EU-AI-regelgeving, die met sancties dreigt voor het niet naleven van bepaalde AI-waarborgen. Maar de weg die voor ons ligt is erg lang.

Hier zijn enkele andere interessante AI-verhalen van de afgelopen dagen:

Voorspellingen voor AI in 2024: Devin legt zijn voorspellingen voor AI in 2024 uit, waarbij hij onder meer ingaat op hoe AI de Amerikaanse voorverkiezingen zou kunnen beïnvloeden en wat de toekomst biedt voor OpenAI.

Tegen pseudo-antropie: Devin schreef ook waarin hij suggereerde dat AI verboden zou worden menselijk gedrag te imiteren.

Microsoft Copilot krijgt muziekcreatie: Copilot, de AI-aangedreven chatbot van Microsoft, kan nu nummers componeren dankzij de integratie met GenAI-muziekapp Suno.

Gezichtsherkenning bij Rite Aid: Rite Aid mag gedurende vijf jaar geen gezichtsherkenningstechnologie gebruiken nadat de Federal Trade Commission had vastgesteld dat het ‘onzorgvuldige gebruik van gezichtsbewakingssystemen’ door de Amerikaanse drogisterijgigant klanten vernederde en hun ‘gevoelige informatie in gevaar bracht’.

De EU biedt computerhulpmiddelen: De EU breidt haar plan uit, dat oorspronkelijk in september werd aangekondigd en vorige maand werd gelanceerd, om binnenlandse AI-startups te ondersteunen door hen toegang te geven tot verwerkingskracht om modellen op de supercomputers van het blok te trainen.

OpenAI geeft het bestuur nieuwe bevoegdheden: OpenAI breidt zijn interne beveiligingsprocessen uit om zich te verdedigen tegen de dreiging van kwaadaardige AI. Een nieuwe ‘veiligheidsadviesgroep’ zal boven de technische teams zitten en aanbevelingen doen aan het management, waarbij het bestuur vetorecht krijgt.

Vraag en antwoord met Ken Goldberg van UC Berkeley: Voor zijn reguliere Actuator-nieuwsbrief sprak Brian met Ken Goldberg, professor aan UC Berkeley, startup-oprichter en ervaren roboticus, om humanoïde robots en bredere trends in de robotica-industrie te bespreken.

CIO’s doen het rustig aan met Gen AI: Ron schrijft dat hoewel CIO’s onder druk staan om de ervaringen te leveren die mensen zien als ze online met ChatGPT spelen, de meesten een doelbewuste, voorzichtige benadering hanteren bij het adopteren van de technologie voor de onderneming.

Nieuwsuitgevers klagen Google aan vanwege AI: Een class action-rechtszaak, aangespannen door verschillende nieuwsuitgevers, beschuldigt Google van ‘overhevelen’[ing] off” nieuws via concurrentiebeperkende middelen, deels via AI-technologie zoals Google Search Genative Experience (SGE) en de Bard-chatbot.

OpenAI-inkten op Axel Springer: Over uitgevers gesproken: OpenAI heeft een deal getekend met Axel Springer, de in Berlijn gevestigde eigenaar van publicaties waaronder Business Insider en Politico, om zijn generatieve AI-modellen te trainen op inhoud van uitgevers en recente artikelen gepubliceerd door Axel Springer toe te voegen aan ChatGPT.

Google brengt Gemini naar meer plaatsen: Google heeft zijn Gemini-modellen geïntegreerd met meer van zijn producten en diensten, waaronder zijn Vertex AI-platform voor de ontwikkeling van kunstmatige intelligentie en AI Studio, de tool van het bedrijf voor het creëren van op AI gebaseerde chatbots en andere ervaringen in die geest.

Meer machinaal leren

Het gekste (en gemakkelijkst verkeerd te interpreteren) onderzoek van de afgelopen twee weken is ongetwijfeld life2vec, een Deens onderzoek dat een groot aantal gegevens over iemands leven gebruikt om te voorspellen hoe iemand is en wanneer hij zal sterven. Ruw!

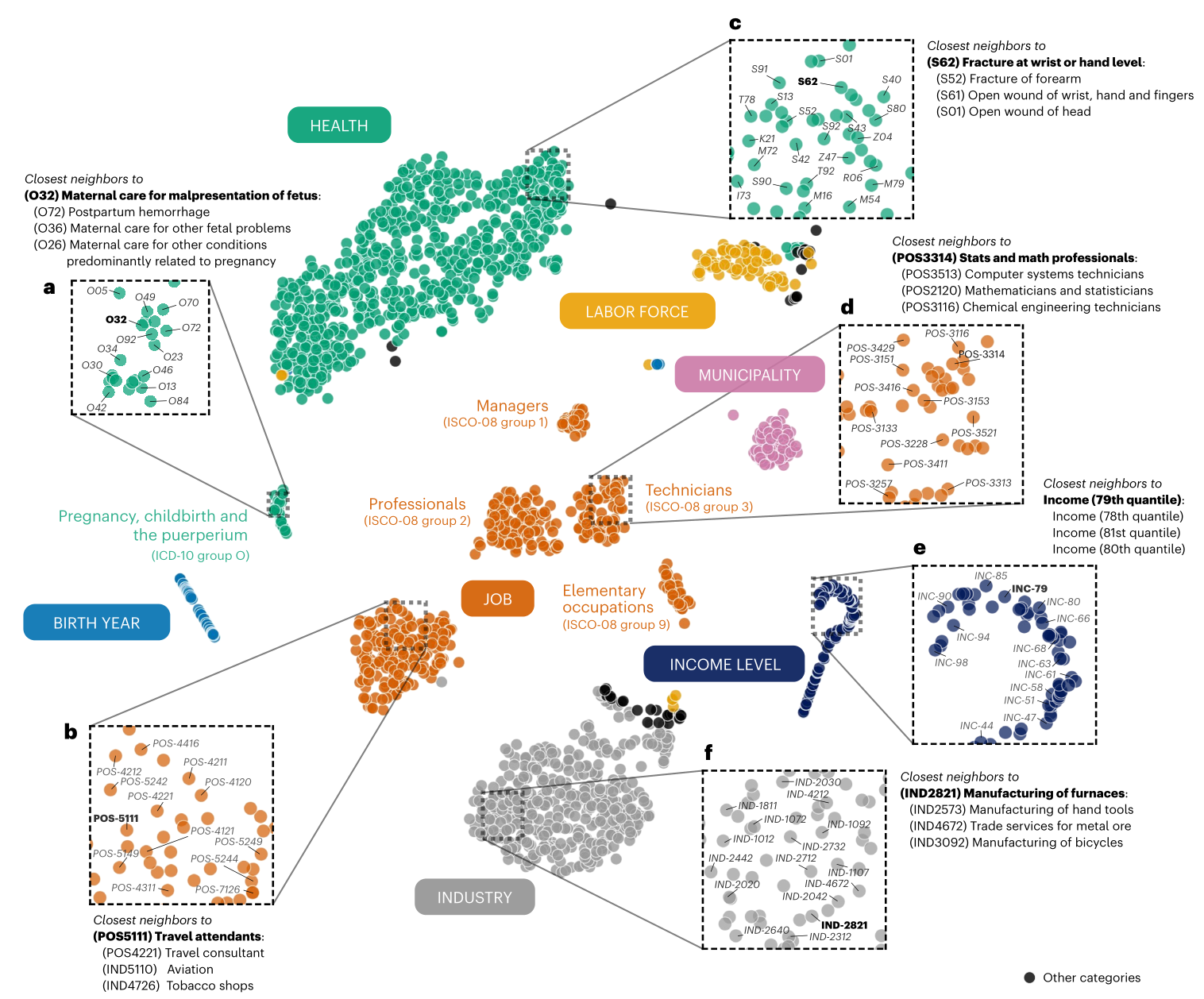

Visualisatie van life2vec’s mapping van verschillende relevante levensconcepten en gebeurtenissen.

De studie claimt geen orakelnauwkeurigheid (dat is trouwens drie keer zo snel), maar heeft eerder tot doel aan te tonen dat als onze levens de som zijn van onze ervaringen, deze paden enigszins kunnen worden geëxtrapoleerd met behulp van de huidige machine learning-technieken. Op basis van opvoeding, opleiding, werk, gezondheid, hobby’s en andere maatstaven kan men redelijkerwijs niet alleen voorspellen of iemand bijvoorbeeld introvert of extravert is, maar ook hoe deze factoren de levensverwachting kunnen beïnvloeden. We zitten hier nog niet helemaal op het niveau van vóór de misdaad, maar je kunt er zeker van zijn dat de verzekeringsmaatschappijen niet kunnen wachten om dit werk in licentie te geven.

Een andere grote claim is gemaakt door CMU-wetenschappers die een systeem hebben gecreëerd met de naam Coscientist, een op LLM gebaseerde assistent voor onderzoekers die veel laboratoriumtaken zelfstandig kan uitvoeren. Het is momenteel beperkt tot bepaalde gebieden van de chemie, maar net als wetenschappers zullen dit soort modellen specialisten zijn.

Hoofdonderzoeker Gabe Gomes vertelde Nature: “Het moment dat ik zag dat een anorganische intelligentie zelfstandig een door mensen bedachte chemische reactie kon plannen, ontwerpen en uitvoeren, was verbazingwekkend. Het was een ‘heilige onzin’-moment.” Het maakt in principe gebruik van een LLM zoals GPT-4, afgestemd op scheikundepapieren, om veelvoorkomende reacties, reagentia en procedures te identificeren en uit te voeren. Je hoeft een laboratoriumtechnicus dus niet te vertellen vier batches van een of andere katalysator te synthetiseren – de AI kan het, en je hoeft niet eens zijn hand vast te houden.

De AI-onderzoekers van Google hadden ook een geweldige week en doken in verschillende interessante grensdomeinen. FunSearch klinkt misschien als Google voor kinderen, maar het staat eigenlijk voor zoekfuncties, die net als Coscientist wiskundige ontdekkingen kunnen doen en helpen vinden. Interessant genoeg gebruikt dit (en andere recentelijk) een paar AI-modellen die vergelijkbaar zijn met de “oude” GAN-architectuur om hallucinaties te voorkomen. De een theoretiseert, de ander evalueert.

Hoewel FunSearch geen revolutionaire nieuwe ontdekkingen zal doen, kan het wel nemen wat er is en het op nieuwe plaatsen verfijnen of opnieuw toepassen, zodat een functie die het ene domein gebruikt en het andere niet kent, kan worden gebruikt om een algoritme dat aan de industriestandaard voldoet, te verbeteren.

StyleDrop is een handig hulpmiddel voor mensen die bepaalde stijlen willen repliceren via generatieve afbeeldingen. Het probleem (zoals de onderzoeker het ziet) is dat als je een stijl in gedachten hebt (bijvoorbeeld ‘pastelkleuren’) en deze beschrijft, het model te veel substijlen van ‘pastelkleuren’ zal hebben om uit te putten, dus de resultaten zullen onvoorspelbaar. Met StyleDrop kunt u een voorbeeld geven van een stijl waar u aan denkt, en het model zal zijn werk daarop baseren – het is in feite een superefficiënte verfijning.

Afbeeldingscredits: Googlen

De blogpost en het artikel laten zien dat het behoorlijk robuust is, waarbij de stijl van elke afbeelding, of het nu een foto, schilderij, stadsgezicht of kattenportret is, wordt toegepast op elk ander type afbeelding, zelfs het alfabet (om de een of andere reden staat het bekend als moeilijk).

Google loopt ook voorop in de generatieve videogame met VideoPoet, die de LLM-basis gebruikt (zoals al het andere tegenwoordig… wat ga je nog meer gebruiken?) om een heleboel videotaken uit te voeren, tekst of afbeeldingen naar video te converteren , een bestaande video uitbreiden of stileren, enzovoort. De uitdaging hier is, zoals elk project duidelijk maakt, niet simpelweg het maken van een reeks beelden die met elkaar verbonden zijn, maar om ze samenhangend te maken over langere perioden (zoals meer dan een seconde) en met grote bewegingen en veranderingen.

Afbeeldingscredits: Googlen

VideoPoet lijkt de bal naar voren te bewegen, maar zoals je kunt zien zijn de resultaten nog steeds behoorlijk raar. Maar dat is hoe deze dingen zich ontwikkelen: eerst zijn ze ontoereikend, dan zijn ze raar, en dan zijn ze verschrikkelijk. Ze zullen waarschijnlijk op een gegeven moment geweldig worden, maar niemand is er nog.

Wat de praktische kant betreft, passen Zwitserse onderzoekers AI-modellen toe om sneeuw te meten. Normaal gesproken zou je vertrouwen op weerstations, maar die kunnen er ver tussenin zitten en we hebben al die prachtige satellietgegevens, nietwaar? Oke. Daarom nam het ETHZ-team openbare satellietbeelden van de Sentinel-2-constellatie, maar zoals chef Konrad Schindler zegt: “Alleen al het kijken naar de witte vlekken in de satellietbeelden kan ons niet meteen vertellen hoe diep de sneeuw is.”

Dus voerden ze terreingegevens voor het hele land in vanuit hun Federal Topography Office (zoals onze USGS) en trainden het systeem om niet alleen schattingen te maken op basis van de witte gebieden in de afbeeldingen, maar ook op basis van grondwaarheid en trendgegevens zoals smeltpatronen. . De resulterende technologie wordt gecommercialiseerd door ExoLabs, met wie ik binnenkort contact zal opnemen voor meer informatie.

Maar een waarschuwing van Stanford: hoe krachtig apps zoals de bovenstaande ook zijn, onthoud dat geen van deze apps veel rekening houdt met menselijke vooroordelen. Als het om gezondheid gaat, wordt het plotseling een groot probleem, en op het gebied van gezondheid worden heel veel AI-tools getest. Onderzoekers van Stanford hebben aangetoond dat modellen voor kunstmatige intelligentie ‘oude medische raciale vormen’ propageren. GPT-4 weet niet of iets waar is of niet, dus het kan en weet ook dat papegaaien oude, weerlegde beweringen doen over groepen, zoals dat zwarte mensen minder longcapaciteit hebben. Nee! Blijf alert als u met welk type AI-model dan ook in de gezondheidszorg en geneeskunde werkt.

Tenslotte is hier een kort verhaal geschreven door Bard met een opnamescript en instructies, weergegeven door VideoPoet. Pas op, Pixar!