Het internet staat vol met persoonlijke artefacten, waarvan de meeste nog lang nadat iemand is overleden online kunnen blijven. Maar wat als die relikwieën worden gebruikt om overleden dierbaren na te bootsen? Dit gebeurt al, en AI-ethici waarschuwen dat deze realiteit een nieuw soort ‘digitale vervolging’ door ‘dode robots’ opent.

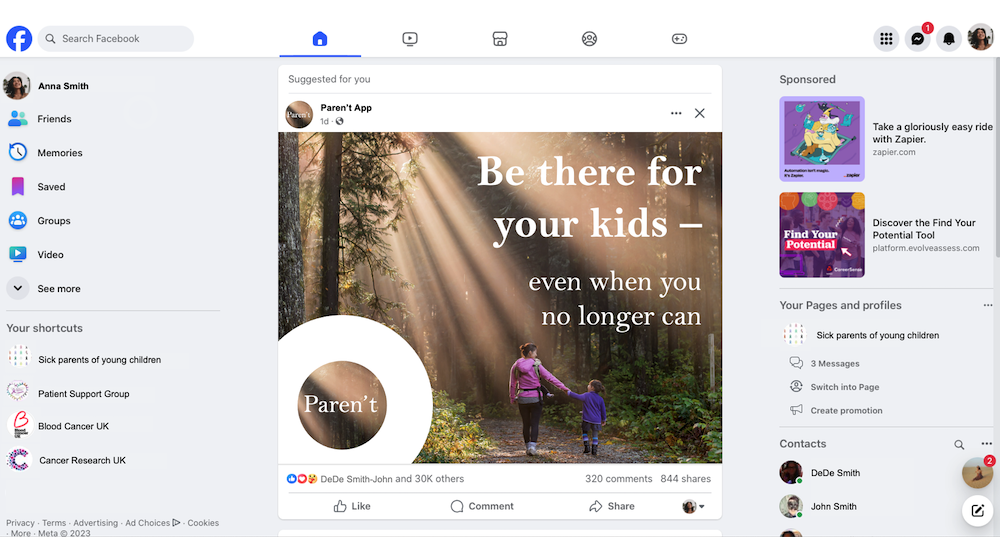

Duizenden jaren lang hebben mensen geprobeerd met overleden dierbaren te communiceren via religieuze rituelen, geestenmediums en zelfs pseudowetenschappelijke technologische benaderingen. Maar de aanhoudende interesse in generatieve AI biedt een geheel nieuwe mogelijkheid voor nabestaanden en familie: het potentieel om te communiceren met chatbot-avatars die zijn getraind op de online aanwezigheid en gegevens van de overledene, inclusief stem- en visuele gelijkenis. Hoewel ze nog steeds expliciet worden geadverteerd als digitale benaderingen, kunnen sommige producten die worden aangeboden door bedrijven als Replika, HereAfter en Persona worden gebruikt (en worden ze in sommige gevallen al gebruikt) om de doden te simuleren.

En hoewel sommigen deze nieuwe realiteit misschien moeilijk te verwerken of zelfs serieus te nemen vinden, is het belangrijk om te onthouden dat de ‘digitale hiernamaals’-industrie niet alleen een nichemarkt is die beperkt is tot kleinere startups. Vorig jaar demonstreerde Amazon het potentieel van zijn Alexa-assistent om de stemmen van een overleden dierbare na te bootsen met slechts een korte audioclip.

[Related: Watch a tech billionaire talk to his AI-generated clone.]

Ethici op het gebied van kunstmatige intelligentie en sciencefictionauteurs onderzoeken en voorspellen deze potentiële situaties al tientallen jaren. Maar voor onderzoekers van het Leverhulme Centre for the Future of Intelligence van de Universiteit van Cambridge is dit ongereguleerde, ongedefinieerde ‘ethische mijnenveld’ er al. En om een punt te maken: ze stelden zich drie fictieve scenario’s voor die gemakkelijk elke dag zouden kunnen gebeuren.

Uit een nieuwe studie gepubliceerd in Filosofie en technologie, vertrouwden AI-ethici Tomasz Hollanek en Katarzyna Nowaczyk-Basińska op een strategie die ‘design fiction’ wordt genoemd. Design fiction, voor het eerst bedacht door sciencefictionauteur Bruce Sterling, verwijst naar “het vermoeden van ongeloof in verandering die wordt bereikt door het gebruik van diëgetische prototypes”. Kortom, onderzoekers schrijven geloofwaardige gebeurtenissen met fictieve visuele hulpmiddelen.

Voor hun onderzoek bedachten Hollanek en Nowaczyk-Basińska drie hyperreële scenario’s van fictieve individuen die in de problemen kwamen met verschillende ‘postmortem aanwezigheid’-bedrijven, en creëerden vervolgens digitale rekwisieten zoals nepwebsites en telefoonscreenshots. De onderzoekers concentreerden zich op drie verschillende demografische categorieën: gegevensdonoren, gegevensontvangers en dienstinteractanten. ‘Datadonors’ zijn de mensen op wie het AI-programma is gebaseerd, terwijl ‘dataontvangers’ worden gedefinieerd als bedrijven of entiteiten die mogelijk over digitale informatie beschikken. Ondertussen zijn ‘service-interactanten’ familieleden, vrienden en iedereen die een ‘deadbot’ of ‘ghostbot’ kan gebruiken.

In een stukje designerfictie is een volwassen gebruiker onder de indruk van het realisme van de chatbot van zijn overleden grootouder, maar krijgt al snel een ‘premium proefversie’ en advertenties voor etenbezorging in de stijl van de stem van zijn familielid. In een andere film creëert een terminaal zieke moeder een dode robot voor hun achtjarige zoon om hen te helpen rouwen. Maar door zich aan te passen aan de reacties van het kind, begint de AI persoonlijke ontmoetingen voor te stellen, waardoor psychologische schade wordt aangericht.

In het laatste scenario tekent een oudere gebruiker een twintigjarig abonnement op een AI-programma in de hoop zijn gezin te troosten. Vanwege de voorwaarden van het bedrijf kunnen hun kinderen en kleinkinderen de dienst echter niet stopzetten, ook al willen ze er geen gebruik van maken.

“De snelle vooruitgang op het gebied van generatieve kunstmatige intelligentie betekent dat bijna iedereen met internettoegang en enige basiskennis een overleden dierbare weer tot leven kan brengen”, zegt Nowaczyk-Basińska. “Tegelijkertijd kan iemand een AI-simulatie achterlaten als afscheidscadeau voor dierbaren die er nog niet klaar voor zijn om hun verdriet op deze manier te verwerken. De rechten van zowel datadonoren als degenen die interactie hebben met AI-diensten voor het hiernamaals moeten in gelijke mate worden beschermd.”

[Related: A deepfake ‘Joe Biden’ robocall told voters to stay home for primary election.]

“Deze diensten lopen het risico grote problemen te veroorzaken bij mensen als ze worden blootgesteld aan ongewenste digitale achtervolgingen als gevolg van alarmerend nauwkeurige AI-reproducties van degenen die ze zijn kwijtgeraakt”, aldus Hollanek. “Het potentiële psychologische effect, vooral in een toch al moeilijke tijd, zou verwoestend kunnen zijn.”

Ethici zijn van mening dat bepaalde waarborgen zo snel mogelijk kunnen en moeten worden geïmplementeerd om dergelijke uitkomsten te voorkomen. Bedrijven moeten gevoelige procedures ontwikkelen voor het “met pensioen gaan” van avatars, en de transparantie behouden over de manier waarop hun diensten werken door middel van risicovrijstellingen. In de tussentijd moeten ‘recreatieve diensten’ beperkt blijven tot uitsluitend volwassen gebruikers, met inachtneming van de wederzijdse toestemming van zowel de gegevensdonoren als hun gegevensontvangers.

“We moeten nu gaan nadenken over hoe we de sociale en psychologische risico’s van digitale onsterfelijkheid kunnen beperken”, beweert Nowaczyk-Basińska.