Hoewel de race om de enorme ambities van AI-bedrijven te versterken lijkt alsof het allemaal om Nvidia draait, is er echte concurrentie op het gebied van AI-acceleratorchips. Het nieuwste voorbeeld: tijdens Intel’s Vision 2024-evenement deze week in Phoenix, Arizona, verstrekte het bedrijf de eerste architectonische details van zijn derde generatie AI-versneller, de Gaudi 3.

Met de vorige chip zei het bedrijf hoe dicht de prestaties in de buurt kwamen van Nvidia’s beste chip van dat moment, de H100, en claimde het een superieure prijs-prestatieverhouding. Met Gaudi 3 wijst hij op de prestaties van het Large Language Model (LLM) waarbij hij volledige superioriteit kan claimen. Maar op de achtergrond doemt Nvidia’s volgende GPU op, de Blackwell B200, die later dit jaar wordt verwacht.

Gaudi-architectuurevolutie

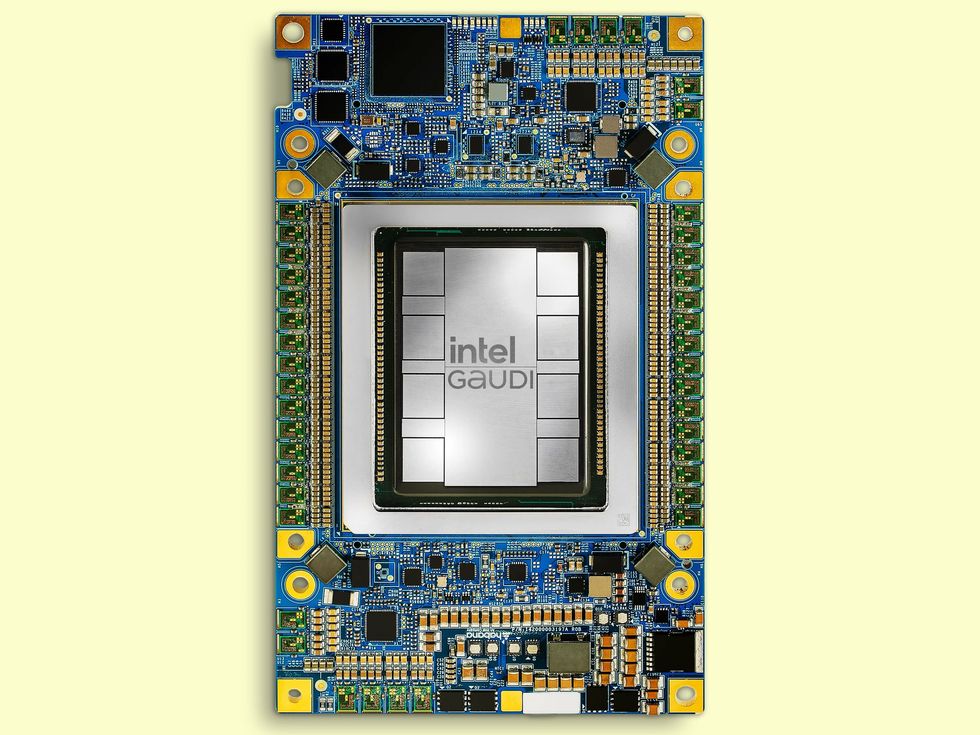

Gaudi 3 verdubbelt de architectuur van zijn voorganger Gaudi 2, in sommige gevallen letterlijk. In plaats van een enkele Gaudi 2-chip bestaat de Gaudi 3 uit twee identieke siliciumdies die met elkaar zijn verbonden door een verbinding met hoge bandbreedte. Elk van hen heeft een centraal gebied van 48 megabytes cachegeheugen. Daaromheen bevindt zich het AI-werkpaard van de chip: vier matrixvermenigvuldigingsmotoren en 32 programmeerbare eenheden die tensorverwerkingskernen worden genoemd. Dit alles is omgeven door geheugenverbindingen en aan de ene kant gedekt door mediaverwerking en netwerkinfrastructuur.

Intel zegt dat dit alles samen resulteert in de productie van twee keer zoveel AI-computers als Gaudi 2, waarbij gebruik wordt gemaakt van de 8-bit drijvende-komma-infrastructuur die naar voren kwam als de sleutel tot het trainen van transformatormodellen. Het biedt ook een verviervoudiging voor berekeningen met het BFloat 16-getalformaat.

Gaudi 3 LLM-prestaties

Intel voorspelt een 40 procent snellere trainingstijd voor het GPT-3 175B grote taalmodel vergeleken met de H100, en zelfs betere resultaten voor de 7 miljard en 8 miljard parameterversies van Llama2.

Concluderend was de concurrentie volgens Intel veel hechter, waarbij de nieuwe chip 95 tot 170 procent van de prestaties van de H100 leverde voor de twee versies van de Llama. Hoewel Gaudi 3 voor het Falcon 180B-model zelfs een viervoudig voordeel behaalde. Het is niet verrassend dat het voordeel minder was dan dat van de Nvidia H200: 80 tot 110 procent voor de Llama en 3,8x voor de Falcon.

Intel claimt dramatischer resultaten bij het meten van de energie-efficiëntie, waarbij het maar liefst 220 procent van de H100-waarde projecteert op de Llama en 230 procent op de Falcon.

“Onze klanten vertellen ons dat wat zij beperkend vinden, het verkrijgen van voldoende stroom voor het datacenter is”, zegt Eitan Medina, Chief Operating Officer van Intel’s Habana Labs.

De resultaten op het gebied van energie-efficiëntie waren het beste wanneer LLM’s de taak kregen langere prestaties te leveren. Medina schrijft dit voordeel toe aan de wiskundige machines van de grote matrix van Gaudí’s architectuur. Dit zijn 512 bits. Andere architecturen gebruiken veel kleinere motoren om dezelfde berekeningen uit te voeren, maar Gaudi’s supersize versie “vereist bijna een orde van grootte minder geheugenbandbreedte om deze te voeden”, zegt hij.

Gaudi 3 versus Blackwell

Het is speculatief om de versnellers te vergelijken voordat ze deze in handen krijgen, maar er zijn weinig gegevens om te vergelijken, vooral op het gebied van geheugen en geheugenbandbreedte. Geheugen is altijd belangrijk geweest in AI, en nu generatieve kunstmatige intelligentie ingang vindt en populaire modellen de omvang van tientallen miljarden parameters bereiken, is het zelfs nog belangrijker geworden.

Beide maken gebruik van geheugen met hoge bandbreedte (HBM), een stapel DRAM-geheugen die bovenop de besturingschip zit. In geavanceerde versnellers bevindt het zich in hetzelfde pakket als het logische silicium en wordt het aan ten minste twee zijden omgeven. Chipmakers gebruiken geavanceerde pakketten, zoals Intel’s EMIB-siliciumbruggen of TSMC’s chip-on-wafer-on-silicium (CoWoS), om een pad met hoge bandbreedte tussen logica en geheugen te bieden.

Zoals de grafiek laat zien, heeft de Gaudi 3 meer HBM dan de H100, maar minder dan de H200, B200 of AMD’s MI300. De geheugenbandbreedte is ook superieur aan die van de H100. Misschien relevant voor Gaudi’s prijsconcurrentievermogen, het gebruikt een goedkopere HBM2e dan andere HBM3 of HBM3e, waarvan wordt aangenomen dat ze een aanzienlijk deel uitmaken van de tienduizenden dollars waarvoor de versnellers zouden worden verkocht.

Een ander vergelijkingspunt is dat de Gaudi 3 is gebouwd met behulp van TSMC’s N5-procestechnologie (ook wel 5-nanometer genoemd). Intel was feitelijk het processorknooppunt achter Nvidia voor Gaudi-generaties, dus het blijft steken in het vergelijken van de nieuwste chip met een chip die minstens een stap hoger stond op de schaal van de wet van Moore. Met Gaudí 3 wordt dat deel van de race iets smaller. De nieuwe chip gebruikt hetzelfde proces als de H100 en H200. Bovendien werkt toekomstige concurrent Blackwell, in plaats van over te stappen op 3-nm-technologie, aan een proces genaamd N4P. TSMC beschrijft dat de N4P tot dezelfde 5-nm-familie behoort als de N5, maar een prestatieverbetering van 11 procent, een 22 procent betere efficiëntie en een 6 procent hogere dichtheid levert.

Wat de wet van Moore betreft, is de grote vraag welke technologie zal worden gebruikt door de volgende generatie Gaudi, momenteel onder de codenaam Falcon Shores. Tot nu toe vertrouwde het product op TSMC-technologie, terwijl Intel zijn gieterijactiviteiten operationeel kreeg. Maar volgend jaar zal Intel zijn 18A-technologie gaan aanbieden aan gieterijklanten en zal 20A intern al gebruiken. Deze twee knooppunten brengen de volgende generatie transistortechnologie, nanosheets, met stroomvoorziening aan de achterkant, een combinatie die TSMC pas in 2026 plant.